分かち合うことで成長します

手を携えて共に行い共に発展する

AIサーバーのコンピューティング能力の急激な向上は、「熱制約」に直面しています。チップの電力密度は1000W/cm²を超え(NVIDIA H100など)、筐体の電力密度は2.4kWから120kWに急上昇し、従来の空冷ソリューションは8~10kWという物理的限界に達しています。この「放熱危機」の根底にあるのは、チップアーキテクチャの量子効果ジレンマ(リーク率が3nmを下回ると急上昇)、データ処理におけるエネルギー消費の不均衡(システムの消費電力の90%以上を占める)、そして大規模モデル学習の需要急増(GPT-4は1回の学習で32.4TWhの電力を消費)です。厳しい政策的制約(中国のPUE ≤ 1.25)とエネルギー効率へのプレッシャーに直面し、液冷技術は限界実験から主流へと移行し、AIコンピューティング能力を解き放つ鍵となっています。

1-AIサーバーの冷却要件の根底にあるロジック

a. チップアーキテクチャと消費電力革命

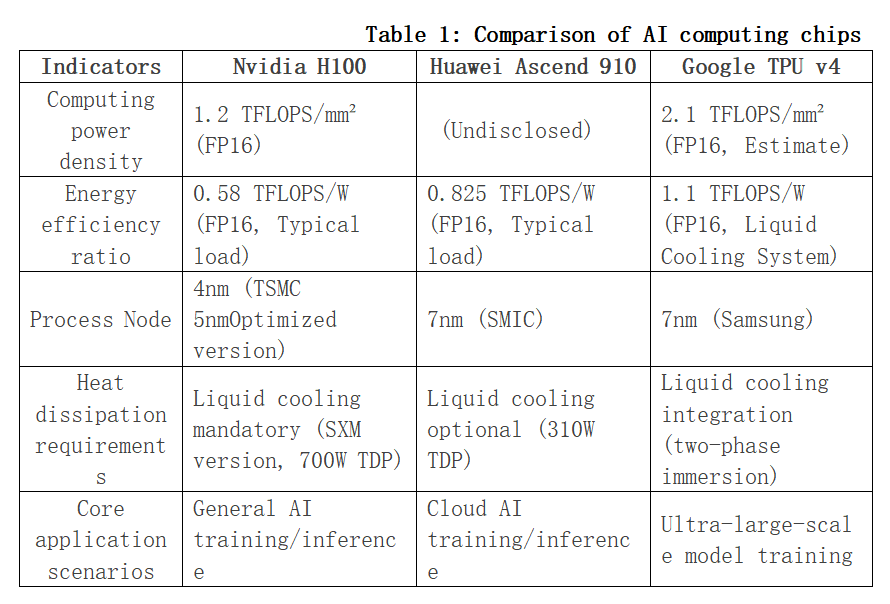

AIチップの演算電力密度(単位面積あたりまたは単位消費電力あたりの演算電力出力)と消費電力は、AIチップの性能を測定する上で重要な指標です。以下は、3つの典型的なチップケースを用いた分析です。

コンピューティング能力が継続的に向上する一方で、放熱とエネルギー効率という物理的な制約により、チップの性能を十分に発揮できていません。この「消費電力の壁」現象は、以下の原因によって生じています。

・放熱の遅れ。チップ電力密度(1000W/cm²超)の成長率が放熱技術の反復速度をはるかに上回り、従来のソリューションでは物理的な限界に達しています。

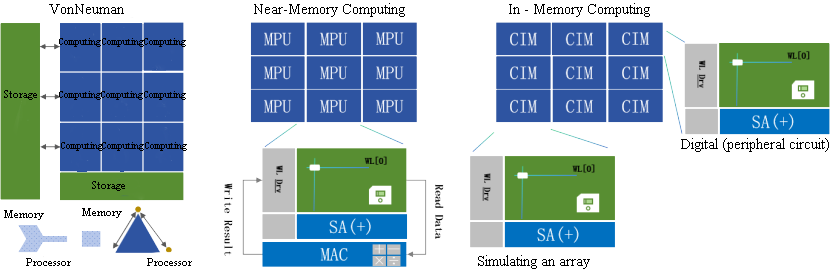

・エネルギー消費構造のアンバランス。物理レベルでは、3nm以下の量子トンネル効果によりエネルギー効率の向上が鈍化し、3Dスタッキングによって放熱効率が30~50%も急激に低下します。アーキテクチャレベルでは、データ処理のエネルギー消費が90%以上を占め、コンピューティング能力の成長率(750倍/2年)とメモリ帯域幅(1.4倍/2年)の間に深刻なアンバランスが生じています。アプリケーションレベルでは、モデルパラメータの爆発的な増加(GPT-4 トレーニングでは 32.4TWh を消費するなど)や動的負荷(瞬間消費電力が TDP を 200% 超える)により、放熱圧力が増大します。

図1: ストレージとコンピューティングの統合

b. キャビネット電力密度の変遷

キャビネット電力密度は、一般的なコンピューティングからAI主導の超高密度へと変革を遂げつつあり、パラダイムは「機器室への適応」から「機器定義室」へと再構築されています。AIコンピューティングの電力需要は、インフラの飛躍的なアップグレードを迫っています。

· 指数関数的な変化により、2011年から2024年にかけて世界平均の密度は2.4kW/キャビネットから9.5kW/キャビネット(CAGR≈12%)に増加しました。AIインテリジェントコンピューティングセンターでは、密度が120kW/キャビネット(NVIDIA GB200 NVL72など)を超え、2030年にはMWレベルに達する可能性があります。

· コアドライブ:AIチップの消費電力の急増(H100シングルカード700W→GB200シングルカード1200W)と大規模モデルトレーニングの需要(GPT-4シングルトレーニングの消費電力は32.4TWh)が「二重らせん効果」を形成し、キャビネット密度をコンピューティングパワーの急増に追い込む必要が生じています。

· 技術革新:空冷限界(8~10kW)が液冷に置き換えられ、コールドプレート型(20~50kW)と液浸型(50~120kW)が高密度をサポートします。電源システムを高電圧直流(HVDC)にアップグレードし、効率は98%超を達成。空間利用率は40%向上(エアダクトを撤去)。液冷によりPUEは1.08に低減。

c. 政策とエネルギー効率が推進

・中国の「東西データコンピューティング」プロジェクト:東部ハブノードのPUEを1.25以下、西部ハブノードのPUEを1.2以下に抑えるという義務付けにより、液冷技術の普及が促進されている。内モンゴルハブを例に挙げると、液浸液冷の採用によりPUEを1.08に低減し、年間2,000万kWh以上の電力を節約できる。

・世界的な炭素排出規制:EUのCSRD指令では、データセンターにライフサイクル全体のカーボンフットプリントの開示を義務付けており、カリフォルニア州の「気候企業データ説明責任法」では、スコープ3排出量も義務的な開示対象に含まれます。液冷技術は、間接排出(冷媒漏洩など)の削減により、コンプライアンス遵守の鍵となっています。

経済的メリットの活用:液冷は空冷に比べて冷却エネルギーを30%~50%削減します。ピーク時と谷間の電力価格差と相まって、投資回収期間は3~5年に短縮されます。

2- 放熱技術の進化と技術ルートの差別化

a. 液冷技術:エッジから主流へ

液冷技術が「エッジ実験」から「放熱基盤」へと移行する過程は、コンピューティングパワー密度とエネルギー効率のバランス調整と、データセンターバリューチェーンの再構築を象徴しています。

· 進化のプロセス:周縁化段階(1960年代~2010年代)、スーパーコンピューティング/軍事産業(Cray-2など)でのみ使用され、材料の腐食性と高コストが制約となっていました。一方、ブレークスルー期(2010年代~2020年代)、GPUの熱密度が500W/cm²(NVIDIA P100)を超え、政策(中国PUE≤1.25)によって商用利用が促進され、コールドプレート変換コストが空冷の1.2倍にまで削減されました。主流(約2~3年)となり、AIキャビネットの電力密度は120kWを超え(NVIDIA NVL72など)、液冷のTCOは空冷より12.2%低く、投資回収期間は3~5年に短縮されました。

・進化論、技術論:「空冷によるチップへの適応」から「チップ定義による放熱」へ、液冷はコンピューティングパワーを解放する中核的な手段となります。産業論:「政策主導の標準→標準によるコスト削減→コストによる普及促進」という好循環を形成します。環境論:データセンターのバリューチェーンを再構築し、冷却システムを「コストセンター」から「省エネ資産」へと転換させます。

・技術ルートの差別化:液冷技術の差別化は、放熱効率と変換コストの駆け引きから生まれます。コールドプレート型は互換性を重視し、ローカル変換によってコストとリスクのバランスを取り、中密度シナリオに適応します。液浸型は物理的な放熱限界を追求し、システム再構築によって熱密度の壁を突破しますが、材料と運用・保守の課題に直面しています。一方、スプレー型はチップレベルの精密温度制御を探求し、光コンピューティングなどの繊細なシナリオへの道を切り開きます。液冷技術の差別化の本質は、「放熱効率 - 変換コスト - 運用・保守の複雑さ」という不可能と思える三角形のトレードオフにあります。コールドプレート型はバランスの上で勝利し、液浸型は物理的限界を追求し、スプレー型は精密な温度制御を目指します。これら3つが相まって、液冷は「技術的オプション」から「コンピューティングパワーの基盤」へと進化を遂げています。

b. チップレベル冷却技術は多次元的なブレークスルーをもたらします

チップレベル冷却技術は、「材料 - 構造 - 制御」の三位一体のイノベーションを経験しています。短期的には、3Dマイクロ流体とコールドプレート液体冷却(キロワットレベルのTDPに対応)が主流となり、長期的には量子冷却と光熱相乗効果によって物理的限界を突破します。その発展は、AIコンピューティングパワーの放出効率とデータセンターのエネルギー効率の進化を直接左右します。

・材料:ダイヤモンド/グラフェンは物理的な熱伝導率限界に近づき、相変化材料は過渡熱衝撃を解決します。

・構造:マイクロ流体とコールドプレートは「外付け」から「チップ埋め込み」へと移行し、放熱経路が短縮され、効率が向上します。

・制御:ソリッドステートアクティブ冷却チップは体積限界を突破し、AIダイナミックレギュレーションは「熱コンピューティング相乗効果」を実現します。

・コアトレンド:これら3つの統合は、放熱を「受動的な熱伝導」から「チップレベルのアクティブ温度制御」へと進化させ、単一チップのキロワットレベルのTDP要件をサポートします。

放熱技術の進化は、「単一点イノベーション」から「システム再構築」へと進化しました。コールドプレート液冷は既存製品の互換性向上を先導し、液浸技術は物理的な放熱限界を突破し、チップレベルのスプレー技術は精密な温度制御を探求しています。これら3つを組み合わせることで、階層型放熱システムを構築します。量子放熱と光熱相乗効果技術が実用化されれば、将来的には単一筐体でMWレベルの超高密度コンピューティングパワーを支えることができるようになります。このプロセスは、放熱パラダイムの革命であるだけでなく、データセンターを「エネルギー消費」から「エネルギー効率の高い資産」へと進化させます。完全な液冷は、2030年までに世界のデータセンターの二酸化炭素排出量を4億5000万トン削減すると推定されています。放熱は、コストセンターからAIコンピューティングパワー経済の中核基盤へと変貌を遂げつつあります。

ご参考になるために、定期に熱設計及び軽量化に関する技術と情報を更新させていただきます。当社にご関心をお持ちいただき、ありがとうございます。