L'échange et le partage favorisent la croissance et

travaillent ensemble pour un développement commun!

Sur la voie menant à la puissance de calcul IA à l'échelle de l'exaflop, le CloudMatrix 384 de Huawei et le cluster GB200 NVL72 de NVIDIA sont devenus deux sommets technologiques mondialement remarqués. Ils ne représentent pas seulement des capacités d'intégration matérielle différentes, mais révèlent plus profondément deux philosophies fondamentalement distinctes pour construire des systèmes de supercalcul.

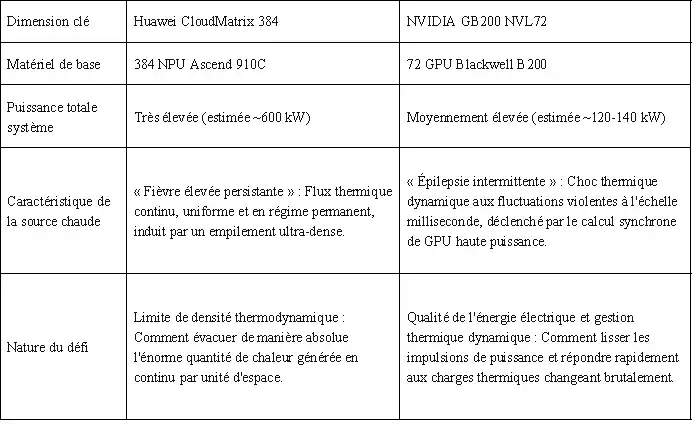

L'un est comparé à une « fièvre élevée persistante », confronté au défi ultime du refroidissement sous un flux thermique continu et extrêmement dense généré par 384 puces fonctionnant en régime permanent. L'autre est décrit comme une « épilepsie intermittente », nécessitant de maîtriser les violentes impulsions de flux thermique produites par la synchronisation de 72 GPU de pointe. Ces deux « diagnostics » différents aboutissent finalement à des « traitements » radicalement distincts – les solutions de refroidissement – et mettent clairement en lumière pour nous deux philosophies d'ingénierie centrales : l'affrontement entre l'ingénierie système déterministe et l'innovation agile par l'écosystème. Pour chaque entreprise de la chaîne d'approvisionnement impliquée, comprendre cet affrontement est essentiel pour définir son propre rôle futur.

1- La racine de la différence fondamentale – Le « diagnostic » détermine le « traitement »

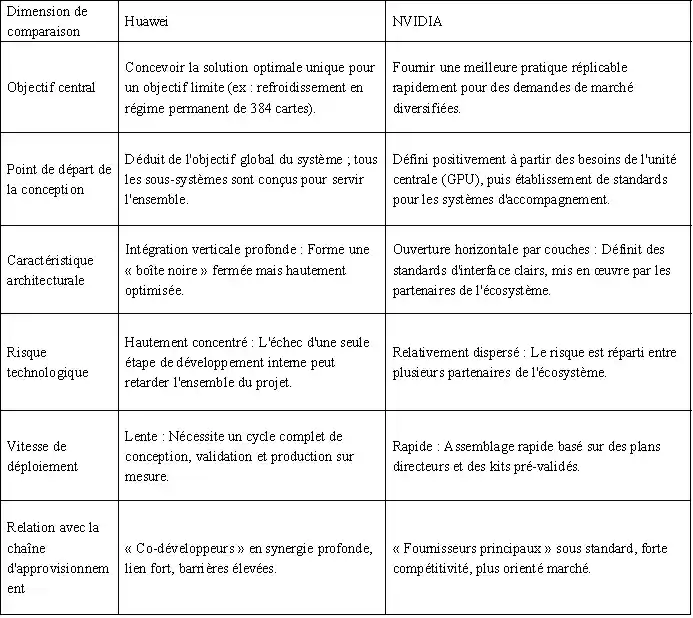

Dès le point de départ de la conception, Huawei et NVIDIA ont emprunté des chemins différents, ce qui a directement façonné leurs caractéristiques thermiques dissemblables.

Tableau 1 : Comparaison des caractéristiques des sources de chaleur pour les deux approches technologiques

Cette différence entre « fièvre persistante » et « épilepsie intermittente » n'est en rien fortuite. Elle reflète le fait qu'en tant que challenger, Huawei a choisi de concentrer ses efforts sur les performances totales du système, poussant sans compromis la densité de calcul à ses limites dans un seul rack. En revanche, en tant que leader, la tâche de NVIDIA est de construire un écosystème capable de collaborer efficacement et de se démocratiser facilement, tout en préservant l'avantage absolu en performance par puce.

2- La matérialisation des philosophies d'ingénierie – Deux voies de refroidissement liquide

Les deux philosophies de conception différentes trouvent leur expression la plus concentrée dans les solutions clés de refroidissement liquide, façonnant toute la pile technologique, de la puce à la salle serveur.

a. Huawei : La pratique du refroidissement liquide par l'ingénierie système déterministe

Il s'agit d'une philosophie de conception descendante, née d'objectifs déterministes au niveau système. Son essence est la mise en œuvre globale, intégrée et hautement fiable du refroidissement en tant qu'élément clé de l'infrastructure, et non seulement comme un composant périphérique.

Figure 1 : Nœud supercalculateur Huawei Ascend 384

· Précision au niveau puce et connexions fiables : Pour assurer un transfert de chaleur efficace de la puce vers la plaque froide, Huawei se concentre sur l'optimisation des matériaux d'interface. Bien que des documents publics montrent des réserves de brevets de pointe dans ce domaine (par exemple, des charges en carbure de silicium à haute sphéricité), leur application spécifique dans le nœud supercalculateur n'est pas divulguée. Ce qui est certain, c'est que leur solution vise nécessairement une très faible résistance thermique d'interface et une fiabilité à long terme pour relever le défi de la « fièvre persistante ».

· Redondance au niveau système et contrôle intelligent : Adoption de conceptions redondantes (comme l'alimentation en liquide en boucle) et développement propre du contrôleur de gestion thermique (TMU) agissant comme « centre nerveux » du système. Ce contrôleur permet une commutation en 0 seconde entre les circuits et utilise l'IA pour la prédiction de pannes, garantissant de manière définie par logiciel la détermination et la fiabilité de la chaîne de refroidissement – une illustration typique de sa pensée systémique.

· Fusion avec l'infrastructure (« fusion froid-électricité ») : Au niveau du rack, intégration physique et gestion unifiée de l'unité de distribution de liquide (CDU) et de l'unité de distribution d'alimentation électrique (PDU). Cette conception « liquide-électricité intégrée » est la réponse d'ingénierie ultime pour gérer une densité de puissance ultra-élevée par rack, simplifier le déploiement et améliorer l'efficacité énergétique (en réduisant le PUE). C'est la matérialisation de sa conception déterministe, de l'idée à la forme physique.

b. NVIDIA : Le cadre du refroidissement liquide par l'innovation agile de l'écosystème

Il s'agit d'une philosophie de conception centrée sur le GPU, visant à habiliter un écosystème mondial en définissant des standards ouverts. Son essence est de fournir un « plan directeur » validé, réduisant le seuil d'adoption pour toute l'industrie et permettant un déploiement à grande échelle efficace et flexible.

Normalisation au niveau puce et conception de référence (VRD) : NVIDIA fournit des conceptions de référence de refroidissement détaillées pour ses GPU (comme la série Blackwell), définissant clairement les interfaces de performance telles que les dimensions physiques de la plaque froide, la puissance thermique de conception (TDP), le débit et la perte de charge. Cela équivaut à fournir une « réponse standard » à tous les fabricants de solutions de refroidissement, encapsulant la complexité dans des pièces standardisées et garantissant la compatibilité et une base de qualité pour les composants fondamentaux.

Figure 2 : Module serveur NVIDIA et plaque de refroidissement liquide à microcanaux

· Collaboration à l'échelle de l'écosystème et certification des solutions : Collaboration approfondie avec des leaders de la gestion thermique et des infrastructures comme Vertiv et Boyd pour co-développer et certifier des solutions de refroidissement liquide au niveau rack. Par exemple, la solution de rack Vertiv™ Titan 2 Ready Liquid Cooling System est un produit pré-validé développé sur la base du plan directeur NVIDIA, permettant aux opérateurs de centres de données d'acquérir rapidement un cluster de refroidissement liquide prêt à l'emploi, comme pour un équipement standard.

· Habillage par jumeau numérique et accélération du déploiement : Via la plateforme NVIDIA Omniverse, fourniture d'outils de jumeau numérique et de simulation pour les systèmes de refroidissement liquide de centres de données. Les clients peuvent concevoir, valider et optimiser leur solution thermique dans un environnement virtuel, réduisant considérablement les coûts et les risques de validation physique et permettant une approche agile de la conception au déploiement.

Pour comprendre plus clairement ces deux voies, nous comparons leurs différences essentielles ci-dessous :

Tableau 2 : Modèle Huawei vs. Modèle NVIDIA : Aperçu des différences clés

3- L'enseignement de l'histoire et la fusion future

La compétition entre ces deux voies n'est pas un cas isolé dans l'histoire de la technologie. Elle représente essentiellement une nouvelle incarnation classique de l'innovation par intégration systémique face à l'innovation par écosystème de plateforme. Huawei ressemble à Apple à l'époque de Steve Jobs, recherchant un contrôle absolu sur l'expérience produit du sommet à la base. NVIDIA, quant à lui, s'apparente davantage à Google Android aujourd'hui, animant la prospérité de tout un écosystème en établissant des standards centraux (système Android / architecture GPU).

Pour le secteur, la tendance future n'est pas le remplacement complet de l'un par l'autre, mais une certaine convergence possible :

· Dans les projets nationaux ou d'entreprise poursuivant une puissance de calcul ultime, l'attrait de « l'ingénierie système déterministe » reste intact.

· Sur le vaste marché commercial du cloud computing, « l'innovation agile par l'écosystème » continuera à se développer grâce à ses avantages en vitesse et en coût.

· L'étincelle de l'intelligence peut naître à l'intersection : intégrer une personnalisation plus poussée et une optimisation collaborative au sein de standards d'écosystème ouverts.

4- Conclusion

Ainsi, la compétition sur le refroidissement entre Huawei et NVIDIA est, par essence, un affrontement entre deux compétences fondamentales à l'ère de l'IA : l'une cherche à atteindre des performances extrêmes et déterministes grâce à une intégration profonde et systémique ; l'autre anime l'innovation agile et la diffusion rapide de l'industrie en construisant des standards ouverts et un écosystème. Cet affrontement trace des choix de trajectoire clairs pour les acteurs de la chaîne industrielle : être une « force spéciale », s'engager profondément et conquérir des forteresses systémiques spécifiques, ou être une « force principale », s'intégrer à l'écosystème et développer le marché sur les vastes plaines des standards. En définitive, le succès ne dépend pas seulement de la technologie elle-même, mais aussi de la compréhension de la logique d'évolution industrielle et d'un positionnement clair de son propre rôle dans le futur paysage.

Nous mettrons régulièrement à jour les informations et technologies relatives à la conception thermique et à l’allègement. Merci de votre intérêt pour Walmate.