Austausch und Teilen fördern Wachstum,

Zusammenarbeit führt zu gemeinsamer Entwicklung.

Auf dem Weg zu Exascale-AI-Rechenleistung sind Huaweis CloudMatrix 384 Super-Node und NVIDIAs GB200 NVL72 Cluster zu zwei weltweit beachteten technologischen Gipfeln geworden. Sie repräsentieren nicht nur unterschiedliche Hardware-Integrationsfähigkeiten, sondern offenbaren tiefgreifend zwei grundlegende Philosophien zum Aufbau von Supercomputing-Systemen.

Der eine Ansatz wird als "kontinuierliches hohes Fieber" metaphorisch beschrieben und steht vor der extremen thermischen Herausforderung, die unter der stabilen Betriebslast von 384 dicht gepackten Chips entsteht. Der andere wird als "intermittierende Epilepsie" charakterisiert und muss heftige, gepulste Wärmeströme bändigen, die entstehen, wenn 72 Top-GPUs synchron arbeiten. Diese unterschiedlichen "Krankheitsbilder" führen letztendlich zu völlig unterschiedlichen "Therapien" – also Kühllösungen – und veranschaulichen klar zwei zentrale Ingenieurphilosophien: Das Duell zwischen deterministischer Systemtechnik und agiler Ökosystem-Innovation. Für jedes Unternehmen in der Lieferkette ist das Verständnis dieses Duells der Schlüssel zur Definition der eigenen künftigen Rolle.

1- Die Ursache des Kernunterschieds – Die "Diagnose" bestimmt die "Therapie"

Am Ausgangspunkt des Designs schlugen Huawei und NVIDIA unterschiedliche Wege ein, was ihre jeweiligen Wärmequellen-Charakteristiken direkt prägte:

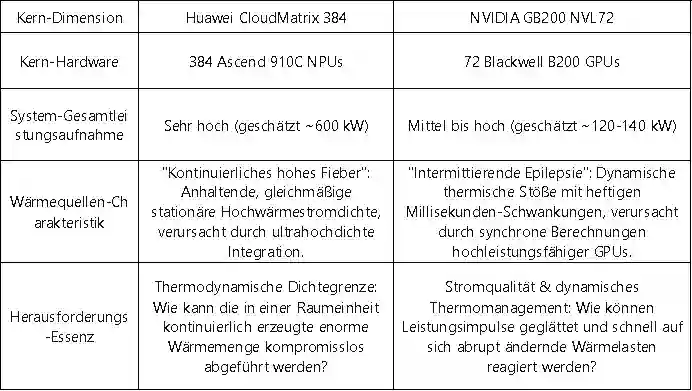

Tabelle 1: Vergleich der Wärmequellen-Charakteristika der beiden technologischen Pfade

Dieser Unterschied zwischen "kontinuierlichem hohen Fieber" und "intermittierender Epilepsie" ist keineswegs zufällig. Er spiegelt wider, dass Huawei als Herausforderer beschlossen hat, die Gesamtsystemleistung als Kernziel anzugehen und um jeden Preis den Durchbruch zur maximal möglichen Rechendichte in einem einzigen Rack zu schaffen. NVIDIA hingegen, als etablierter Marktführer, hat die Aufgabe, ein effizient zusammenarbeitendes und leicht zu verbreitendes Ökosystem aufzubauen, während es gleichzeitig den absoluten Leistungsvorsprung seiner Einzelchips sicherstellt.

2- Die Materialisierung der Ingenieurphilosophie – Zwei Pfade der Flüssigkühlung

Die beiden unterschiedlichen Designphilosophien manifestieren sich am deutlichsten in den entscheidenden Flüssigkühlungslösungen und prägen den gesamten Technologiestack vom Chip bis zum Rechenzentrumsraum.

a. Huawei: Die Flüssigkühlungspraxis deterministischer Systemtechnik

Dies ist eine von oben nach unten umgesetzte Designphilosophie, die für das systemweite Ziel der Deterministik geschaffen wurde. Ihr Kern liegt darin, die Wärmeabfuhr nicht nur als Zubehör, sondern als kritischen Teil der Infrastruktur ganzheitlich, integriert und mit hoher Zuverlässigkeit zu realisieren.

Abbildung 1: Huawei Ascend 384 Super-Node

· Chip-Level-Präzision und zuverlässige Verbindung: Um die effiziente Wärmeübertragung vom Chip zum Kühlkörper zu gewährleisten, konzentriert sich Huawei auf die technische Optimierung der Grenzflächenmaterialien. Obwohl öffentliche Dokumente zeigen, dass das Unternehmen in diesem Bereich (z.B. mit hochsphärischen Siliziumkarbid-Füllstoffen) über wegweisende Patentreserven verfügt, sind die konkreten Anwendungsdetails im Super-Node nicht öffentlich. Sicher ist, dass deren Lösung extrem niedrige Grenzflächenwiderstände und langfristige Zuverlässigkeit für die Herausforderung des "kontinuierlichen hohen Fiebers" anstrebt.

· System-Level-Redundanz und intelligente Steuerung: Es werden redundante Designs wie z.B. ringförmige Flüssigkeitsversorgung eingesetzt, und ein eigenentwickelter Flüssigkühlungs- und Wärmemanagement-Controller (TMU) fungiert als systemischer "Schaltzentrale". Dieser Controller ermöglicht eine unterbrechungsfreie (0-Sekunden) Umschaltung zwischen Leitungen und nutzt KI für Fehlervorhersagen. Auf diese Weise gewährleistet er durch softwaredefinierte Ansätze die Deterministik und Zuverlässigkeit der Wärmeabfuhrkette – ein typisches Beispiel für systemtechnisches Denken.

· Infrastruktur-Integration ("Kälte-Strom-Fusion"): Auf Rack-Ebene werden die Flüssigkühlungs-Verteilungseinheit (CDU) und die Hochspannungs-Stromverteilungseinheit (PDU) physikalisch integriert und einheitlich verwaltet. Dieses "integrierte Kühl- und Stromdesign" ist die ultimative technische Antwort auf extrem hohe Leistungsdichten pro Rack, die Vereinfachung der Bereitstellung und die Verbesserung der Energieeffizienz (Senkung des PUE). Es verkörpert die physische Umsetzung des deterministischen Designs vom Konzept zur realen Form.

b. NVIDIA: Der Flüssigkühlungsrahmen agiler Ökosystem-Innovation

Dies ist eine Designphilosophie, die den GPU-Kern in den Mittelpunkt stellt und durch die Definition offener Standards das globale Ökonomie befähigt. Ihr Kern liegt darin, einen validierten "Bauplan" bereitzustellen, der die Anwendungsschwelle für die gesamte Branche senkt und effiziente, flexible Skalierbarkeit ermöglicht.

· Chip-Level-Standardisierung und Referenzdesign (VRD): NVIDIA stellt für seine GPUs (z.B. die Blackwell-Serie) detaillierte thermische Referenzdesigns bereit, die physikalische Abmessungen des Kühlkörpers, die thermische Verlustleistung (TDP), Durchflussmenge, Druckverlust und andere Leistungsschnittstellen klar definieren. Dies liefert allen Kühlungsherstellern eine "Standardantwort", kapselt die Komplexität in Standardkomponenten und sichert so Kompatibilität und eine qualitative Grundlinie für die Basiskomponenten.

Abbildung 2: NVIDIA Server-Modul und Mikrokanal-Flüssigkühlkörper

· Ökosystem-Level-Kollaboration und Lösungszertifizierung: Enge Zusammenarbeit mit führenden Wärmemanagement- und Infrastrukturanbietern wie Vertiv und Boyd zur gemeinsamen Entwicklung und Zertifizierung von Rack-Level-Flüssigkühlungslösungen. Beispielsweise ist Vertivs "Tier 2 Ready"-Rack-Lösung ein vorab validiertes Produkt, das auf dem NVIDIA-Bauplan basiert. Sie ermöglicht es Rechenzentrumsbetreibern, Flüssigkühlungscluster wie Standardgeräte zu beschaffen und schnell einsatzbereit zu erhalt en.

· Digitaler Zwilling und beschleunigte Bereitstellung: Über die NVIDIA Omniverse-Plattform werden digitale Zwillinge und Simulationstools für Rechenzentrums-Flüssigkühlungssysteme bereitgestellt. Kunden können Kühllösungen in einer virtuellen Umgebung entwerfen, validieren und optimieren, was die Kosten und Risiken physischer Validierung erheblich reduziert und den Prozess von der Entwicklung bis zur Bereitstellung agil gestaltet.

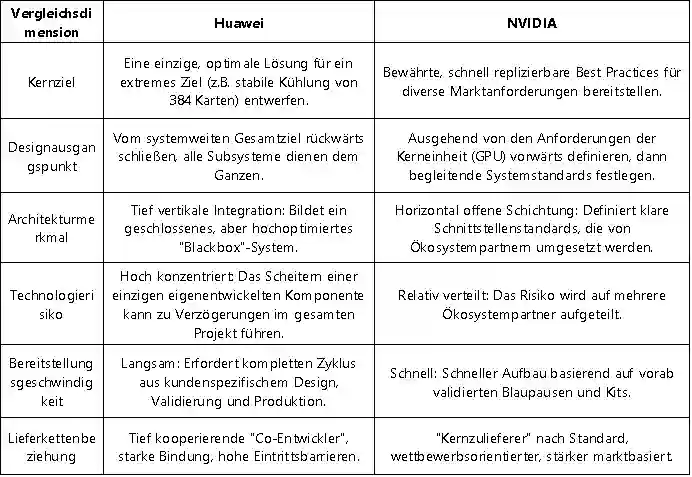

Um diese beiden Pfade klarer zu verstehen, sind deren Kernunterschiede hier gegenübergestellt:

Tabelle 2: Huawei-Modell vs. NVIDIA-Modell: Überblick der Schlüsselunterschiede

3- Die Lehren der Geschichte und die künftige Konvergenz

Der Wettbewerb zwischen diesen beiden Pfaden ist in der Technologiegeschichte kein Einzelfall. Im Kern handelt es sich um eine weitere klassische Ausprägung des Gegensatzes zwischen systemintegrativer Innovation und plattformökologischer Innovation. Huawei ähnelt dem Apple der Steve-Jobs-Ära, indem es nach absoluter Kontrolle über das Produkterlebnis von der obersten bis zur untersten Ebene strebt. NVIDIA hingegen ähnelt eher dem heutigen Google Android, indem es durch die Festlegung von Kernstandards (Android-System/GPU-Architektur) den Wohlstand des gesamten Ökosystems antreibt.

Für die Branche liegt der künftige Trend wahrscheinlich nicht in der vollständigen Verdrängung des einen durch den anderen Ansatz, sondern in einer gewissen Konvergenz:

· Bei nationalen oder unternehmenskritischen Projekten, die extreme Rechenleistung anstreben, bleibt der Reiz des deterministischen Systemengineering ungebrochen.

· Im breiten kommerziellen Cloud-Computing-Markt wird sich die agile Ökosystem-Innovation aufgrund ihrer Geschwindigkeits- und Kostenvorteile weiter ausdehnen.

· Der funkelnde Funke der Erkenntnis könnte in der Schnittmenge entstehen: der Integration tieferer Maßschneiderung und kooperativer Optimierung in offene Ökosystem-Standards.

4- Schlussfolgerung

Der Wettstreit zwischen Huawei und NVIDIA im Bereich der Wärmeabfuhr ist daher im Wesentlichen ein Aufeinandertreffen zweier Kernkompetenzen im KI-Zeitalter: Die eine Seite strebt durch tiefe Integration von Systemtechnik nach deterministischer, maximaler Leistung. Die andere Seite treibt durch den Aufbau offener Standards und eines Ökosystems die agile Innovation und schnelle Verbreitung in der Industrie voran. Dieses Duell zeichnet den Teilnehmern in der Lieferkette klare Pfade vor: Sollen sie als "Spezialeinheit" tiefe Bindungen eingehen und konkrete, systemweite Festungen erobern? Oder als "Hauptarmee" in das Ökosystem eintreten und auf der weiten Ebene der Standards Märkte erschließen? Letztendlich hängt der Ausgang nicht nur von der Technologie selbst ab, sondern noch mehr vom Einblick in die Entwicklungslogik der Industrie und von der klaren Definition der eigenen Position in der künftigen Landkarte.

Wir werden regelmäßig Informationen und Technologien zu Wärmedesign und Leichtbau aktualisieren und mit Ihnen teilen. Vielen Dank für Ihr Interesse an Walmate.