La comunicazione e la condivisione promuovono la crescita

Uniamo le forze per lo sviluppo

Sulla strada verso la potenza di calcolo AI Exascale (centinaia di miliardi di miliardi di operazioni al secondo), il super-nodo CloudMatrix 384 di Huawei e il cluster GB200 NVL72 di NVIDIA sono diventati due vette tecnologiche di rilievo globale. Essi rappresentano non solo diverse capacità di integrazione hardware, ma rivelano profondamente due filosofie fondamentali nella costruzione di supercomputer.

Il primo è stato paragonato a una "febbre alta persistente", che affronta la sfida estrema di raffreddare 384 chip funzionanti in modo stabile in uno spazio estremamente denso e stagnante. Il secondo è stato descritto come un "attacco epilettico intermittente", che deve domare il violento flusso di calore pulsante generato quando 72 GPU top di gamma lavorano in sincronia. Queste due diverse "eziologie" portano infine a "prescrizioni" radicalmente diverse – le soluzioni di raffreddamento – e ci mostrano chiaramente due filosofie ingegneristiche centrali a confronto: ingegneria sistemica deterministica contro innovazione ecosistemica agile. Per ogni azienda nella catena di fornitura, comprendere questo confronto è la chiave per definire il proprio ruolo futuro.

1- L'origine della differenza fondamentale – "L'eziologia" determina la "prescrizione"

Fin dal punto di partenza della progettazione, Huawei e NVIDIA hanno intrapreso strade diverse, il che ha plasmato direttamente le loro caratteristiche termiche distinte:

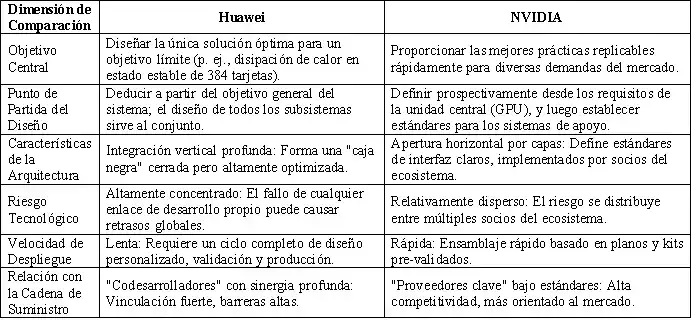

Tabella 1: Confronto delle caratteristiche della sorgente di calore delle due linee tecnologiche

Questa differenza tra "febbre alta persistente" e "attacco epilettico intermittente" non è affatto casuale. Riflette il fatto che Huawei, in qualità di sfidante, ha scelto di concentrarsi sulle prestazioni totali del sistema, cercando a tutti i costi di spingere al limite la densità computazionale in un singolo rack. NVIDIA, in quanto leader, ha il compito di costruire un ecosistema che collabori in modo efficiente e sia facile da adottare, garantendo al contempo il vantaggio assoluto nelle prestazioni del singolo chip.

2- Materializzazione della filosofia ingegneristica: due percorsi di raffreddamento a liquido

Le due diverse filosofie progettuali si manifestano in modo più evidente nelle critiche soluzioni di raffreddamento a liquido, plasmandone l'intero stack tecnologico dal chip alla sala server.

a. Huawei: La pratica del raffreddamento a liquido nell'ingegneria sistemica deterministica

Questa è una filosofia progettuale top-down, nata per un obiettivo deterministico a livello di sistema. Il suo cuore è realizzare il raffreddamento come parte integrante e ad alta affidabilità dell'infrastruttura chiave, attraverso un'implementazione ingegneristica globale, non come un semplice componente di supporto.

Figura 1: Super-nodo Huawei Ascend 384

· Lavorazione di precisione a livello chip e connessioni affidabili: Per garantire un trasferimento efficiente del calore dal chip alla piastra fredda, Huawei si concentra sull'ottimizzazione ingegneristica dei materiali d'interfaccia. Sebbene la documentazione pubblica indichi riserve di brevetti all'avanguardia in questo campo (ad es., riempitivi al carburo di silicio con alta sfericità), la loro specifica applicazione nel super-nodo non è stata resa pubblica. È certo che la loro soluzione persegua un'impedenza termica di interfaccia estremamente bassa e un'affidabilità a lungo termine, per affrontare la sfida della "febbre alta persistente".

· Ridondanza a livello di sistema e controllo intelligente: Adotta design ridondanti come l'alimentazione ad anello del liquido e sviluppa autonomamente il Thermal Management Unit (TMU) per il raffreddamento a liquido come "centro nevralgico" del sistema. Questo controller può eseguire commutazioni a 0 secondi tra le linee e utilizza l'AI per la previsione dei guasti, garantendo la deterministica e l'affidabilità del circuito termico in modalità software-defined, tipica espressione del suo pensiero ingegneristico di sistema.

· Fusione con l'infrastruttura ("Fusione Freddo-Elettrico"): A livello rack, integra fisicamente e gestisce in modo unificato l'unità di distribuzione del liquido di raffreddamento (CDU) con l'unità di distribuzione elettrica ad alta tensione (PDU). Questo design "unificato freddo-elettrico" è la risposta ingegneristica definitiva per gestire l'enorme densità di potenza per rack, semplificare la distribuzione e migliorare l'efficienza energetica (riducendo il PUE), ed è l'attuazione fisica della sua progettazione deterministica, dall'idea alla forma.

b. NVIDIA: Il quadro del raffreddamento a liquido nell'innovazione ecosistemica agile

Questa è una filosofia progettuale centrata sulla GPU, che abilita l'ecosistema globale definendo standard aperti. Il suo cuore è fornire un "progetto" collaudato per abbassare la soglia di applicazione in tutto il settore e realizzare una distribuzione efficiente, flessibile e su larga scala.

· Standardizzazione a livello chip e progetto di riferimento (VRD): NVIDIA fornisce progetti di riferimento di raffreddamento dettagliati per le sue GPU (es. serie Blackwell), definendo chiaramente le interfacce prestazionali come dimensioni fisiche della piastra fredda, Thermal Design Power (TDP), portata e caduta di pressione. Ciò equivale a fornire a tutti i produttori di soluzioni termiche la "risposta standard", incapsulando la complessità all'interno di componenti standardizzati, garantendo compatibilità e una linea di base qualitativa per i componenti fondamentali.

Figura 2: Modulo server NVIDIA e piastra di raffreddamento a liquido a microcanali

· Collaborazione a livello ecosistema e certificazione delle soluzioni: Collabora in profondità con i principali produttori di gestione termica e infrastrutture come Vertiv e Boyd, per sviluppare e certificare congiuntamente soluzioni di raffreddamento a liquido a livello rack. Ad esempio, la soluzione rack Tier 2 Ready di Vertiv è un prodotto pre-validato sviluppato sul progetto NVIDIA, consentendo agli operatori di data center di ottenere cluster a liquido plug-and-play rapidamente, come per l'acquisto di attrezzature standard.

· Abilitazione tramite gemello digitale e accelerazione della distribuzione: Tramite la piattaforma NVIDIA Omniverse, fornisce strumenti di simulazione e gemelli digitali per i sistemi di raffreddamento a liquido dei data center. I clienti possono progettare, validare e ottimizzare le soluzioni termiche in un ambiente virtuale, riducendo enormemente costi e rischi della validazione fisica e realizzando un processo agile dal design alla distribuzione.

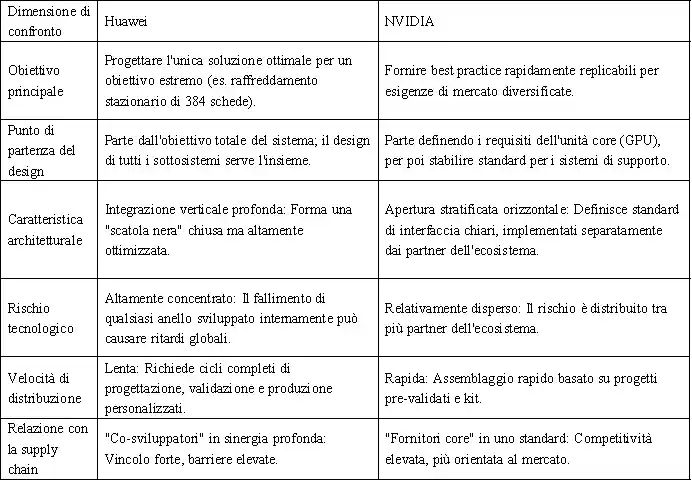

Per comprendere più chiaramente questi due percorsi, ne confrontiamo le differenze fondamentali di seguito:

Tabella 2: Modello Huawei vs. Modello NVIDIA: Panoramica delle differenze chiave

3- L'illuminazione della storia e la convergenza futura

Il confronto tra questi due percorsi non è un caso isolato nella storia della tecnologia. È essenzialmente un'altra classica manifestazione dell'innovazione sistemica integrata contro l'innovazione ecosistemica a piattaforma. Huawei assomiglia all'Apple dell'era Steve Jobs, perseguendo il controllo assoluto dall'alto verso il basso sull'esperienza del prodotto; NVIDIA assomiglia di più all'Android di Google di oggi, guidando la prosperità dell'intero ecosistema stabilendo standard fondamentali (sistema Android/architettura GPU).

Per il settore, la tendenza futura non sarà la sostituzione completa di uno con l'altro, ma potrebbe emergere un certo grado di convergenza:

· Nei progetti nazionali o aziendali che cercano la potenza di calcolo estrema, il fascino dell' "ingegneria sistemica deterministica" rimane intatto.

· Nel vasto mercato commerciale del cloud computing, l' "innovazione ecosistemica agile" continuerà ad espandersi grazie ai suoi vantaggi in velocità e costo.

· Le scintille di innovazione potrebbero nascere nell'area di intersezione: integrare una maggiore personalizzazione e ottimizzazione sinergica all'interno di standard ecosistemici aperti.

4- Conclusione

Pertanto, la contesa sul raffreddamento tra Huawei e NVIDIA è, in sostanza, uno scontro tra due competenze fondamentali nell'era dell'IA: una parte cerca di realizzare prestazioni estreme e deterministiche attraverso l'integrazione profonda dell'ingegneria di sistema; l'altra parte guida l'innovazione agile e la rapida diffusione del settore costruendo standard aperti e un ecosistema. Questo confronto traccia scelte di percorso chiare per i partecipanti alla catena del valore: agire come "forze speciali", legandosi in profondità per espugnare fortezze sistemiche specifiche, o come "esercito principale", integrarsi nell'ecosistema per esplorare mercati nelle vaste pianure degli standard. Alla fine, il risultato non dipende solo dalla tecnologia in sé, ma anche dalla comprensione della logica di evoluzione del settore e dal posizionamento chiaro di se stessi nella mappa futura.

Condivideremo regolarmente aggiornamenti e informazioni su tecniche di progettazione termica e alleggerimento, per la vostra consultazione. Grazie per l'interesse verso Walmate.